Un querido amigo y colega nos comparte el presente artículo, escrito por Ashlee Gardner de Emory University, editado por Lisa Lock, revisado por Robert Egan, publicado en junio 25 de 2025 en el boletín de noticias de Emory University, republicado en Phys.org y posteriormente traducido por nosotros para este espacio. Vemos de que se trata…

Últimamente, la inteligencia artificial (IA) está en todas partes: en las noticias, en los podcasts y en cada rincón de la casa. Un nuevo término de moda, la Inteligencia Artificial General (IAG), domina las conversaciones y plantea más preguntas que respuestas.

Entonces, ¿qué es la IAG? ¿Reemplazará empleos o abrirá soluciones a los mayores desafíos del mundo? ¿Se alineará con las prioridades sociales o las redefinirá? ¿Nuestro futuro es más como "Los Supersónicos" o "Terminator"? Las respuestas no son sencillas. Dependen de cómo definamos la IA y de qué esperamos que haga.

Como primer director del Centro para el Aprendizaje de IA, el Centro Comunitario de Emory para la alfabetización en IA y un componente central de la iniciativa AI.Humanity, Joe Sutherland conoce bien las preguntas difíciles sobre la IA. El verano pasado, emprendió una gira estatal para desmitificar la IA y empoderar a los georgianos con habilidades para prosperar en un futuro centrado en la tecnología. Diversos públicos, compuestos por profesionales, empresarios, legisladores y estudiantes, compartieron muchas de las mismas preguntas fundamentales.

En esta sesión de preguntas y respuestas, Sutherland responde a nuestras preocupaciones más urgentes sobre la IAG, ayudándonos a superar el revuelo y encontrar respuestas a muchas interrogantes.

¿Cuál es la diferencia entre inteligencia artificial, inteligencia artificial general y superinteligencia artificial?

Las definiciones han cambiado con el tiempo, lo que ha generado cierta confusión. La inteligencia artificial no es una tecnología monolítica. Es un conjunto de tecnologías que automatizan tareas o imitan decisiones que los humanos normalmente tomamos. Delegamos la autoridad para tomar esas decisiones a una máquina.

Tradicionalmente, cuando se hablaba de inteligencia artificial general (IAG), se referían a Skynet de "Terminator" o a HAL de "2001: Una odisea del espacio", máquinas que supuestamente tenían libre albedrío y se aproximaban a las capacidades humanas.

Hoy en día, algunos laboratorios importantes de investigación han redefinido la IAG como un programa informático capaz de realizar tareas específicas tan bien como, o incluso mejor, que los humanos expertos.

Superinteligencia artificial (ISA) es el término moderno para lo que antes llamábamos superinteligencia o singularidad. Es lo que solíamos entender como IAG: robots humanoides que superan la inteligencia humana.

¿Ya tenemos IA?

Depende de la definición que uses. Si usas la definición orientada a tareas de los laboratorios, sí. La IA es excelente recuperando información y resumiéndola de una manera que cualquier persona que la evalúe diría: "¡Vaya, esto es bastante bueno!".

Los modelos de lenguaje extenso (LLM por sus siglas en inglés) como ChatGPT pueden superar a los humanos que intentan ingresar a la facultad de medicina en el examen MCAT. Pero eso no es inteligencia real. Es como darle Google a un estudiante durante un examen. La verdadera IA debería mostrar razonamiento, no solo recuperación de información y coincidencia de patrones.

¿Cuál es la diferencia entre el razonamiento y lo que hace la IA actual?

Los modelos actuales dan la impresión de razonar, pero simplemente investigan información secuencialmente y luego la resumen. No comprenden el mundo; solo predicen qué palabra viene después basándose en patrones. Al evaluarse en tareas de razonamiento reales, como la Torre de Hanói o acertijos de lógica, los LLM suelen fallar a menos que hayan memorizado las respuestas.

El humor es otro ejemplo donde la IA se queda corta. Desde una perspectiva humanística, el humor se encuentra en la intersección entre la comodidad y la incomodidad. Ese límite cambia constantemente. Los chatbots solo repiten cosas que han visto en el pasado; no comprenden ese límite. El verdadero humor es algo que no pueden hacer.

De igual manera, las empresas a menudo carecen de datos que indiquen tendencias más amplias que ocurren "fuera" de la empresa. Sus modelos de IA, entrenados con datos internos, no pueden sintetizar dónde hemos estado y hacia dónde vamos. Eso requeriría razonamiento, intuición y alineación de valores; cosas que nos cuesta articular incluso para nosotros mismos.

Entonces, ¿cuán cerca estamos realmente de la IAG?

Si usamos la antigua definición de IAG, como "Terminator", creo que estamos muy lejos. Las LLM no nos acercarán a la meta porque carecen de razonamiento ni de capacidades creativas intuitivas. No les hemos proporcionado un marco para descubrir nueva información de forma eficiente. Tendremos que desarrollar arquitecturas completamente nuevas si queremos acercarnos.

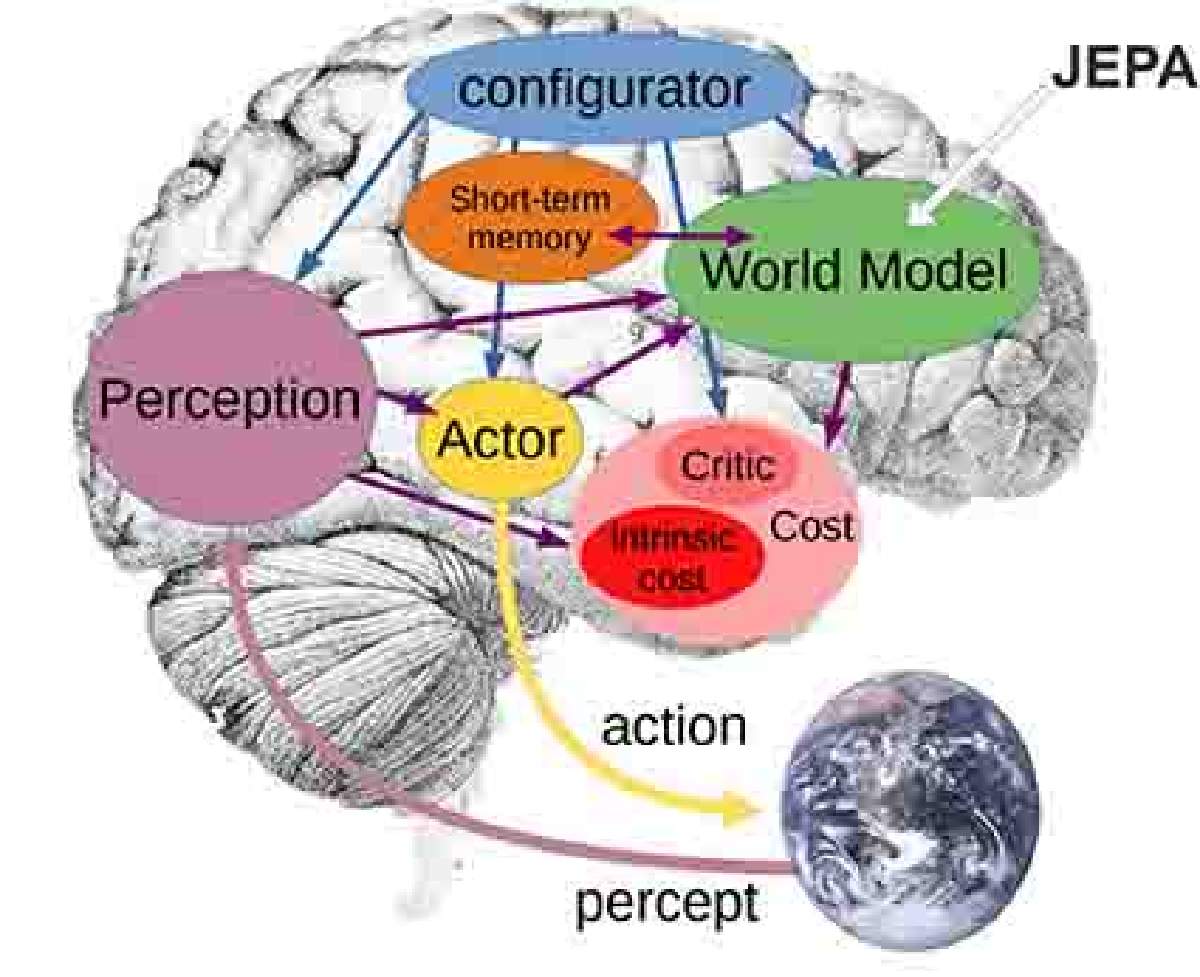

Un paso en la dirección correcta es la arquitectura predictiva de integración conjunta (JEPA por sus siglas en inglés). En lugar de encadenar palabras como una LLM, infiere relaciones más profundas entre conceptos y activa esas inferencias para lograr un objetivo de mayor nivel.

Es tranquilizador saber que arrojar todas las entradas de la enciclopedia de la sociedad en una LLM no produce inteligencia a nivel humano. Lo estoy resumiendo, por supuesto. La humanidad es más compleja de lo que se ve a simple vista.

¿Cuáles son las mayores promesas y riesgos de la IA general?

Las tecnologías actuales son fantásticas. Permiten a las personas realizar tareas en horas que antes requerían días. La promesa es la eficiencia: herramientas que pueden resumir investigaciones, asistir en diagnósticos médicos y ayudar a planificar la lista de la compra semanal. Esto ayudará a las personas a ganar más dinero, a pasar más tiempo con sus familias o a sus aficiones, y a vivir vidas más largas y saludables.

El riesgo no es la tecnología, sino la falta de comprensión pública. Necesitamos capacitación en IA para que la gente entienda cuándo se está utilizando correctamente y cuándo no.

La clave es proporcionar un marco que equilibre el valor de lo que se está construyendo con la propiedad intelectual que sustenta estos modelos, es decir, los conjuntos de datos.

Algunas empresas han argumentado en los tribunales que extraer datos personales sin consentimiento ni compensación está justificado porque contribuye al progreso social. Es un argumento manipulador y problemático.

Si se representan las necesidades de quienes contribuyen a estas tecnologías y se les recompensa adecuadamente, se incentivará una mayor innovación y uso. También necesitamos pruebas exhaustivas para identificar dónde estos modelos fallan o producen resultados sesgados.

¿Podemos alinear la IA con los valores humanos?

Esa es una cuestión más social que técnica. El verano pasado, impartí charlas en Georgia para la gira estatal de desarrollo de la fuerza laboral de IA de Emory, junto con la Fundación Rowen y la Cámara de Comercio de Georgia, a la que llamamos "IA + Tú". Un miembro del público preguntó: "¿Cómo podemos garantizar que los modelos de IA que estamos construyendo tengan valores estadounidenses?".

Lo que hace especial a Estados Unidos es que valoramos la oportunidad de disentir. Nunca vamos a estar de acuerdo en todo, así que la pregunta más importante es: ¿Cómo creamos un sistema con barreras de seguridad que se adapten a nuestros valores sociales en constante evolución? ¿Cuál es el marco que nos permite mantener un debate sólido y, en última instancia, tomar buenas decisiones?

Estas preguntas no son nuevas con la llegada de la IA. Nos las hemos estado planteando durante siglos. Pero el rápido auge de la tecnología y su poder cada vez más centralizado nos obligan a replantearnos cómo abordamos la acción colectiva.

Si logramos una IA general eficaz, ¿cuál será el mejor futuro?

Creo que el mejor futuro, con todas estas tecnologías, es aquel que nos permita realizar trabajos más significativos y dedicar menos tiempo a cosas que no disfrutamos. Esto significa más tiempo para la innovación y la resolución creativa de problemas.

La investigación en IA de Emory ya está transformando la atención médica, mejorando el diagnóstico y el tratamiento de enfermedades como el cáncer, las cardiopatías y la diabetes. Utilizamos el análisis de texto para descubrir patrones en las políticas públicas que harán que la gobernanza sea más eficiente y equitativa. Nuestros investigadores también investigan cómo la IA puede proteger los derechos de las personas y hacer crecer las empresas.

La IA ofrece más beneficios que inconvenientes si empoderamos a las personas a través de la educación y las incluimos en el diálogo para que puedan defender sus derechos y los de sus seres queridos.

Si se implementan con criterio, estas tecnologías pueden ampliar el potencial humano, no reemplazarlo.

Fuente: https://news.emory.edu/stories/2025/06/er_artificial_general_intelligence_qa_25-06-2025/story.html